AI to nie tylko modele i dane - to także ciepło. Dużo ciepła. Wraz ze wzrostem mocy obliczeniowej serwerów rośnie też zapotrzebowanie na efektywne, niezawodne i skalowalne chłodzenie. Klasyczne wentylatory przestają wystarczać, gdy TDP pojedynczego GPU przekracza 700 W, a cała szafa dobija do 120 kW. W tym wpisie pokazujemy, jak dziś wygląda chłodzenie serwera AI w praktyce, kiedy warto przejść na chłodzenie cieczą, co daje immersion, jak projektować data center AI pod kątem rozkładu ciepła i jak automatyzacja HVAC z użyciem ML zmienia sposób zarządzania infrastrukturą.

Chłodzenie serwera AI przy 1000W TDP - dlaczego wentylatory już nie wystarczają?

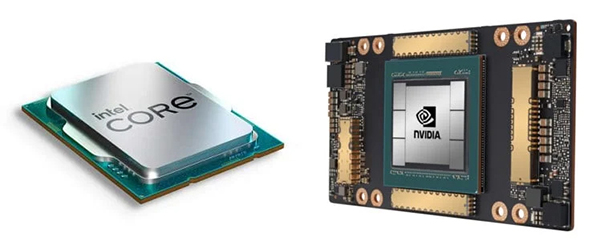

Jeszcze kilka lat temu standardowy airflow i pasywne radiatory wystarczały do obsługi większości serwerów rackowych. Dziś jednak, gdy jeden procesor potrafi generować 700–1000 W ciepła, a serwer z 8xGPU przekracza 120 kW na szafę, sytuacja wygląda zupełnie inaczej. Chłodzenie serwera AI na takim poziomie wymaga innego podejścia – nie tylko do samego sprzętu, ale do całego projektu data center. Wentylatory o wyższym ciśnieniu statycznym, tunele chłodzące, separacja ciepłych i zimnych stref - to wszystko już nie wystarcza, gdy masz do czynienia z gęsto upakowanymi konfiguracjami deep learning.

Największym wyzwaniem jest utrzymanie stabilnej temperatury GPU bez throttlingu, który przy zadaniach AI przekłada się wprost na wydłużenie czasu inferencji i spadek efektywności energetycznej. Coraz więcej firm decyduje się więc na hybrydowe układy chłodzenia serwera, łączące klasyczne powietrze z obiegiem cieczy. Takie podejście nie tylko stabilizuje temperaturę komponentów, ale też obniża koszty HVAC nawet o 30–40%, co przy dużej serwerowni oznacza dziesiątki tysięcy złotych rocznie. W praktyce - jeśli Twoja infrastruktura AI ma działać ciągle, nie możesz liczyć tylko na airflow z przedniej kratki. Trzeba spojrzeć na chłodzenie jako na strategiczny komponent środowiska AI.

Serwer chłodzony cieczą - kiedy direct-to-chip ma więcej sensu niż airflow?

Systemy direct-to-chip zyskują dziś przewagę wszędzie tam, gdzie klasyczne chłodzenie przestaje dawać radę. Chodzi o sytuacje, gdy nie wystarczy już podnieść liczby wentylatorów czy zwiększyć przepływu powietrza - bo to prowadzi do drastycznego wzrostu zużycia energii i hałasu, a i tak nie zapewnia optymalnych temperatur na rdzeniach GPU czy CPU. Serwer chłodzony cieczą, a dokładnie direct liquid cooling (DLC), pozwala przenosić ciepło bezpośrednio z hot spotów komponentów - blok chłodzący przylega do procesora, a chłodziwo krąży w zamkniętym obiegu z wymiennikiem ciepła.

Co ciekawe, coraz więcej konstrukcji - jak np. Dell PowerEdge XE9680 czy Supermicro 421GE-TNHR - oferuje już fabryczne przygotowanie pod chłodzenie cieczą. Nie trzeba przebudowywać całego data center AI, by zyskać korzyści z DLC - wystarczy zastosować gotowe zestawy płyt montażowych, kolektorów i loopów cieczy. Efekt? Temperatury na poziomie 55–60°C przy pełnym obciążeniu H100, brak throttlingu, mniejsze zużycie wentylatorów i niższy pobór mocy całego systemu. Jeśli zależy Ci na efektywności i gęstości - a to kluczowe w AI - serwer chłodzony cieczą nie jest już eksperymentem, tylko realną alternatywą dla klasyki.

Immersion cooling w praktyce - jak wygląda chłodzenie zanurzeniowe w środowiskach AI?

Gdy mówimy o najbardziej zaawansowanych formach chłodzenia, immersyjne rozwiązania zaczynają wyprzedzać wszystko inne pod względem efektywności. W tej technologii cały serwer - wraz z GPU, CPU, płytą główną i zasilaczem - zanurza się w specjalnym dielektrycznym płynie, który odbiera ciepło z każdego komponentu bezpośrednio, bez potrzeby wentylatorów. W zastosowaniach AI to ogromna przewaga - znikają wąskie gardła związane z hotspotami, przepływem powietrza czy nierównomiernym rozkładem ciepła.

W testach przeprowadzanych przez dostawców takich jak Submer czy GRC immersion cooling pozwala zbić zużycie energii HVAC o 40–60%, a Power Usage Effectiveness (PUE) schodzi nawet do poziomu 1.03. Dodatkowym bonusem jest możliwość odzysku ciepła i wykorzystania go np. do ogrzewania biurowca czy produkcji ciepłej wody użytkowej, co szczególnie docenią firmy dbające o ślad węglowy. Nie oznacza to jednak, że immersion cooling pasuje do każdego środowiska. Wymaga zmiany myślenia o infrastrukturze, integracji z systemami odzysku energii i odpowiednio dobranych szaf zanurzeniowych. Ale jeśli Twoje data center AI planuje 100 kW+ na rack - trudno dziś o bardziej opłacalną inwestycję.

Data center AI pod wysokim obciążeniem - jak planować gęstość szaf i rozkład cieplny?

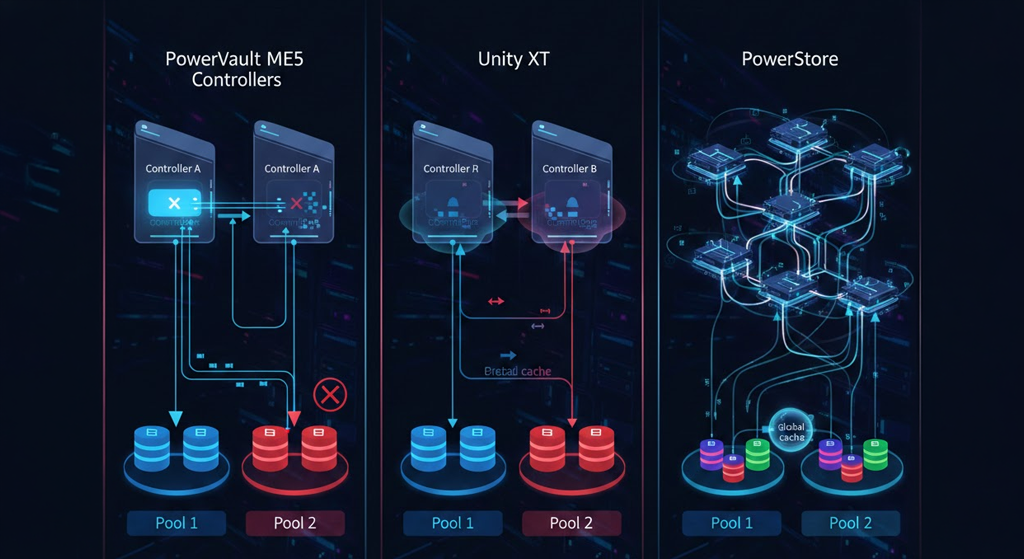

Planowanie data center AI różni się od klasycznych środowisk serwerowych. Tu nie wystarczy po prostu „dorzucić klimatyzatorów”. Trzeba analizować rozkład obciążenia termicznego w czasie i przestrzeni, brać pod uwagę profile pracy GPU, sekwencje treningowe modeli i skoki poboru mocy. Przy TDP przekraczającym 700–800 W na akceleratorze, a takich akceleratorów w jednej szafie może być 8–10, trzeba myśleć o chłodzeniu serwera nie tylko na poziomie jednostki, ale całej szafy i ciągu rackowego.

Dlatego w nowoczesnych projektach często pojawiają się dedykowane strefy chłodzenia cieczą, zawory dynamiczne, adaptacyjne kontrolery przepływu oraz sensory różnic temperatury na poziomie U. Rozsądnie rozplanowane data center AI to nie tylko PUE - to stabilność operacyjna i możliwość skalowania bez konieczności migracji do nowej lokalizacji. Dell, Lenovo i Supermicro już dziś oferują rozwiązania gotowe do integracji z tego typu środowiskami - z kolektorami chłodzenia cieczą, redundancją pomp, wymiennikami ciepła i monitoringiem pracy cieczy w czasie rzeczywistym. Jeśli zaczynasz projekt z myślą o AI, nie myśl o chłodzeniu jako dodatku - zaplanuj je na równi z mocą obliczeniową.

Chłodzenie serwera sterowane AI - automatyka, sensory i algorytmy ML w HVAC

Automatyzacja chłodzenia to kolejny krok w stronę większej efektywności - zwłaszcza gdy system ma dynamicznie reagować na zmienne obciążenia. Dzięki połączeniu sensorów temperatury, przepływu cieczy, ciśnienia i poboru mocy z systemami ML, chłodzenie serwera AI może być sterowane adaptacyjnie - z dokładnością do pojedynczego GPU. Firmy takie jak Schneider Electric, Vertiv czy Rittal wdrażają systemy HVAC z uczeniem maszynowym, które przewidują, kiedy i gdzie wystąpi szczyt obciążenia - i odpowiednio wcześniej aktywują przepływy lub zmieniają priorytety pomiędzy sekcjami racków.

To nie tylko wygoda, ale też realna oszczędność. Dynamiczne chłodzenie pozwala ograniczyć pobór mocy o 10–20%, wydłużyć żywotność wentylatorów, zmniejszyć zużycie cieczy i zoptymalizować działanie pomp. Do tego dochodzi integracja z BMS i DCIM, co pozwala zarządzać całym środowiskiem z jednego panelu. Jeśli zależy Ci na długoterminowej opłacalności i stabilności, warto pomyśleć o chłodzeniu nie jako o fizyce - ale o części systemu zarządzanego przez software. Chłodzenie serwera w AI to dziś również kod, dane i predykcja. I coraz więcej firm to rozumie.