Trenowanie dużych modeli AI to nie zabawa dla zwykłych desktopów. Jeśli chcesz uruchomić LLM, przetwarzać big data albo budować własne rozwiązania deep learningowe - musisz wiedzieć, jaki serwer do AI faktycznie udźwignie to zadanie. Wybór nie kończy się na „weź coś z RTX-em” - liczy się cała platforma: GPU, CPU, RAM, storage, chłodzenie i skalowalność.

Serwer do AI - jakich GPU naprawdę potrzebujesz do głębokiego uczenia?

Dobór GPU do zadań związanych z AI nie sprowadza się dziś do stwierdzenia „weź coś z serii RTX”. Jeśli zależy Ci na wydajności przy trenowaniu dużych modeli, generatywnych sieci neuronowych czy LLM, to liczy się nie tylko liczba rdzeni CUDA, ale też VRAM, przepustowość pamięci, wsparcie dla tensor core’ów i kompatybilność z frameworkami AI. W realnych wdrożeniach produkcyjnych standardem są karty NVIDIA H100, A100, L40s oraz A800, dostępne m.in. w takich konstrukcjach jak Dell PowerEdge XE9680, Lenovo SR670 V2 czy Supermicro AS-4125GS-TNRT.

Jeśli nie potrzebujesz aż takiej mocy, ale chcesz trenować mniejsze modele lub fine-tunować istniejące architektury - np. w środowiskach badawczo-rozwojowych - dobrze sprawdzają się również RTX A6000, 4090 czy nawet 4070 Ti Super, które wciąż oferują bardzo dobrą wydajność w przeliczeniu na koszt. Wybierając GPU, nie kieruj się wyłącznie benchmarkami gamingowymi - istotniejsze będą: ilość VRAM (minimum 24 GB w poważnych projektach), obsługa mixed precision (FP16, BF16) i efektywność przy pracy z dużymi batchami danych. I co ważne - serwery do AI powinny umożliwiać rozbudowę GPU, najlepiej w formie modularnej lub z pełnym wsparciem dla PCIe Gen5.

Deep learning server w praktyce - ile RAM, jaki storage, jak z chłodzeniem?

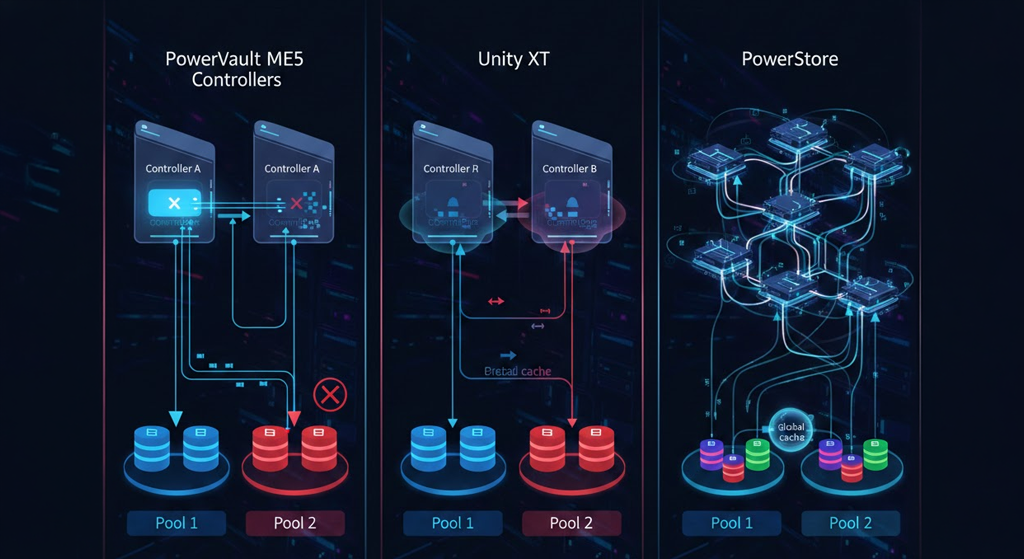

Kiedy patrzysz na konfigurację serwera do AI, łatwo skupić się tylko na GPU. Ale prawda jest taka, że bez odpowiednio dobranej reszty platformy - RAM-u, CPU, storage’u i chłodzenia - wydajność GPU zostanie ograniczona. Dlatego w profesjonalnych środowiskach AI minimum to 128 GB RAM, a w serwerach klasy enterprise często spotykasz 512 GB, 1 TB albo nawet 4 TB, zwłaszcza jeśli chodzi o pracę na wielu modelach lub złożone pipeline’y preprocessingowe. Co ważne - pamięć powinna być typu ECC, bo błędy pamięci przy długim treningu to coś, czego naprawdę nie chcesz doświadczyć.

Jeśli chodzi o storage, NVMe to dziś obowiązek. SATA SSD nie da rady przy szybkim ładowaniu danych z ogromnych zbiorów, zwłaszcza jeśli masz kilka GPU pracujących równolegle. Serwery jak Lenovo SR670 V2 czy Dell PowerEdge XE9680 oferują nie tylko miejsca na wiele GPU, ale też pełne wsparcie dla ultraszybkich SSD NVMe Gen4, a nowsze modele - nawet Gen5. Do tego dochodzi temat chłodzenia - 4 czy 8 kart H100 to ogromna emisja ciepła, więc albo inwestujesz w serwer z aktywnym chłodzeniem cieczą (np. Supermicro), albo zadbasz o wysokiej klasy system wentylacyjny i redundantne PSU minimum 2 kW.

Tylko wtedy deep learning server ma sens w środowisku produkcyjnym i nie będzie wymagał ręcznego restartu co drugi dzień.

Serwer do machine learning - jaki CPU ma sens, gdy pracujesz z dużymi modelami?

Wbrew pozorom, CPU w serwerze AI nie jest tylko od „obsługi systemu”. Przy dużych pipeline’ach machine learning, preprocessing danych, dekodowanie, augmentacja czy same operacje IO często potrafią zająć więcej czasu niż sam trening - o ile CPU nie nadąża. Dlatego dobry serwer do machine learning powinien mieć procesor, który nie będzie wąskim gardłem. Na rynku dominują dziś dwie architektury: Intel Xeon Scalable (gen. 5) oraz AMD EPYC 9004 „Genoa”. Obie oferują od kilkudziesięciu do ponad 90 rdzeni fizycznych na socket, pełne wsparcie dla DDR5, mnóstwo linii PCIe Gen5 i świetną efektywność przy pracy wielowątkowej.

W praktyce - jeśli planujesz trenować wiele modeli równolegle lub pipeline’ować dane w czasie rzeczywistym, celuj w min. 32–64 rdzenie fizyczne i taktowanie powyżej 3 GHz. Modele serwerów jak Supermicro AS-4125GS-TNRT czy Dell PowerEdge R760xa (niezawodne, ale rzadziej wspominane niż XE9680) pozwalają na pełną elastyczność pod względem CPU-GPU-RAM. W środowiskach testowych lub przy budżecie poniżej 30 tys. zł warto rozważyć Threadripper PRO 7000 lub Xeon W-3400, które nieco ograniczają rozbudowę GPU, ale spokojnie pociągną 2–3 topowe karty i kilka VM-ek jednocześnie. Dobrze dobrany CPU nie przyspieszy treningu bezpośrednio - ale znacząco skróci czas całego cyklu ML.

Nie tylko H100 - alternatywne GPU do AI, które warto znać (i nie przepłacać)

Jeśli myślisz o AI server hardware i wszędzie widzisz tylko H100 i A100, to... nic dziwnego. To potwory obliczeniowe, które świetnie skalują się w klastrach i obsługują największe modele. Tylko że nie każdy projekt tego potrzebuje. Dla firm średniej wielkości lub startupów lepszym wyborem mogą być mniej „hype’owane” karty, które kosztują ułamek ceny, a w inference czy fine-tuningu wcale nie ustępują aż tak mocno. Przykłady? NVIDIA RTX A6000, L40s, A800 czy nawet 4090 - to GPU, które w stacjach roboczych lub rackowych serwerach spokojnie poradzą sobie z trenowaniem transformerów czy modeli językowych o rozmiarze do kilku miliardów parametrów.

Do tego dochodzi AMD Instinct MI300, który zyskuje na popularności, szczególnie w środowiskach open source, gdzie nie ma potrzeby korzystania z rozwiązań z ekosystemu CUDA. Na rynku są też serwery, które łączą różne klasy GPU w jednym chassis, np. Dell PowerEdge T640 - świetny do środowisk test-dev, gdzie możesz miksować RTX 4070 Ti z A6000 i sprawdzać zachowanie modelu w różnych konfiguracjach. Nie każde AI wdrożenie potrzebuje H100 - a bardzo często warto kupić 2–3 „tańsze” karty, które dadzą elastyczność i szybki time-to-market, bez czekania na zatwierdzenie zakupu za pół miliona złotych.

Elastyczne serwery do AI - kiedy tower wystarczy, a kiedy potrzebujesz blade’ów?

Nie każdy projekt AI wymaga serwerowni i chłodzenia wodnego. Jeśli dopiero budujesz środowisko lub rozwijasz dział R&D, dobrze skonfigurowany tower może spokojnie wystarczyć - np. Dell T640 z 2x Xeon Gold, 512 GB RAM i kilkoma slotami na karty RTX A6000 to konstrukcja, która zmieści się pod biurkiem, a jednocześnie obsłuży kilka tygodni solidnego treningu. W wielu przypadkach to właśnie form factor ma kluczowe znaczenie - nie zawsze potrzebujesz full racka, szczególnie przy mniejszych datasetach i krótszych iteracjach modelu.

Z drugiej strony - jeśli myślisz o skalowaniu, multi-GPU, integracji z klastrem lub środowiskiem hybrydowym, warto postawić na modularne rozwiązania rack lub blade. Platformy takie jak Dell PowerEdge FX2s (4 węzły FC640/FC830) pozwalają na łatwą rozbudowę, szybką rekonfigurację zasobów i lepsze zarządzanie energią oraz siecią. To rozwiązanie dla tych, którzy myślą o AI jako inwestycji długoterminowej, a nie eksperymencie. Elastyczne serwery do AI pozwalają dobrać formę do potrzeb - a to często ważniejsze niż sam benchmark kart.

Chmura czy fizyczny serwer do AI? Kiedy opłaca się postawić własne środowisko

Decyzja, czy pójść w chmurę, czy kupić własny sprzęt, to nie kwestia ideologii - tylko czasu, skali i przewidywalności. Chmura ma ogromne zalety: nie płacisz na start, skalujesz się „na żądanie”, testujesz wiele konfiguracji bez zamrażania środków. Jeśli budujesz MVP, trenujesz modele raz na miesiąc lub po prostu nie masz jeszcze infrastruktury - chmura (np. OVH, Azure, AWS) będzie najbardziej opłacalnym wyborem. Ale to nie znaczy, że zawsze będzie tanio.

Kiedy projekt rośnie, modele są coraz większe, a inference działa w trybie 24/7 - chmura potrafi kosztować kilkanaście razy więcej niż fizyczny deep learning server. W dodatku dochodzą tematy compliance, ochrona danych, zgodność z RODO - i wtedy własna infrastruktura daje spokój. Jeśli liczysz na stabilne obciążenie, masz własny zespół i kontrolujesz cały pipeline - serwer do AI kupiony raz, dobrze dobrany i rozbudowywalny, zaczyna się spłacać bardzo szybko. W 2025 roku koszt 8xH100 w chmurze potrafi dojść do kilkudziesięciu tysięcy złotych miesięcznie - a fizyczny sprzęt zwraca się po 4–6 miesiącach. Dlatego decyzja musi być skrojona pod realny scenariusz, nie tylko Excelową symulację.