Model już wytrenowany? Teraz czas, by zaczął działać na produkcji – szybko, stabilnie i bez wąskich gardeł. Właśnie tu wchodzi w grę AI inference, czyli faza, w której Twój model przetwarza rzeczywiste dane i zwraca wyniki w czasie rzeczywistym. Ale żeby to miało sens, potrzebujesz dobrze dobranego sprzętu: serwera inference, który uniesie obciążenie, z odpowiednim GPU i CPU zoptymalizowanym nie pod trening – a pod wydajność i skalowalność zapytań.

AI inference w praktyce – co naprawdę wpływa na czas odpowiedzi i skalowalność?

Jeśli wdrażasz modele AI w środowisku produkcyjnym, wiesz, że czas odpowiedzi staje się ważniejszy niż sam wynik modelu. To właśnie w fazie AI inference – czyli podczas wnioskowania z już wytrenowanego modelu – pojawia się presja na milisekundy. Dla systemów obsługujących chatboty, analizy w czasie rzeczywistym, IoT, monitorowanie wideo czy silniki rekomendacji – liczy się przede wszystkim latencja, przepustowość i skalowalność. Nie chodzi już o to, jak dokładny jest model – tylko czy potrafi obsłużyć 10 000 żądań jednocześnie, bez opóźnień.

Na ten wynik wpływa więcej czynników, niż może się wydawać. Kluczowe są:

-

wydajność GPU inference,

-

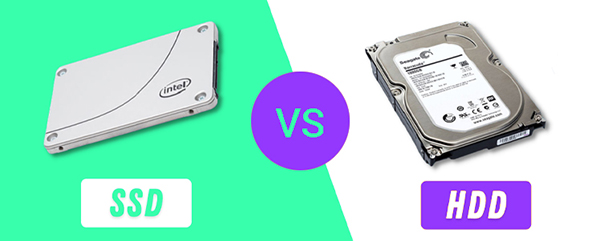

niska latencja RAM i dysków NVMe,

-

dobre chłodzenie,

-

sprawna obsługa wielu żądań równolegle,

-

wsparcie dla formatów INT8 czy FP16.

W nowoczesnych środowiskach wykorzystuje się narzędzia typu Triton Inference Server, które dynamicznie zarządzają kolejkami żądań i dopasowują obciążenie do dostępnych zasobów GPU. Dobrze zoptymalizowany serwer inference może przetworzyć nawet setki tysięcy zapytań dziennie, przy zachowaniu niskiej latencji i minimalnego zużycia energii. To dlatego dziś mówi się o „produkcyjnym inference” jako o oddzielnej specjalizacji – to nie jest już po prostu odpalenie modelu, ale pełnoprawna architektura operacyjna.

GPU inference bez bottlenecków – jak dobrać akcelerator do liczby zapytań?

Wybór GPU do inference to coś więcej niż „czy to ma dużo VRAM-u”. Dla większości modeli wykorzystywanych w produkcji (LLM, sieci wizualne, klasyfikatory, silniki rekomendacji) ważniejsze od surowej mocy jest to, jak dany GPU obsługuje obliczenia niskiej precyzji (FP16, INT8), jak wygląda jego architektura przepustowości oraz czy umożliwia jednoczesną obsługę wielu strumieni. Inaczej mówiąc – GPU inference nie może być „zapieczone” jednym dużym modelem, jeśli ma działać w środowisku z wysokim QPS (queries per second).

Z popularnych modeli wykorzystywanych obecnie w systemach inference warto wymienić NVIDIA A2, A10, L40s oraz Jetson Orin dla edge AI – wszystkie oferują znakomity stosunek wydajności do kosztu, są wspierane przez frameworki takie jak TensorRT, Triton i Red Hat AI Inference Server, i nie wymagają specjalnych chassis z potężnym chłodzeniem.

Przykładowo: Dell PowerEdge R760xa z A10 potrafi obsłużyć do 3 razy więcej żądań niż starsze rozwiązania na bazie T4, przy niższym poborze energii i stabilniejszej pracy pod dużym obciążeniem. Co ważne – GPU inference warto planować nie tylko pod kątem mocy, ale też dostępności i skalowalności w obrębie szafy rackowej. Jeśli dziś zaczynasz od jednej karty, ale wiesz, że za pół roku potrzebujesz czterech – upewnij się, że płyta główna, zasilanie i chłodzenie na to pozwolą.

Serwer inference z myślą o LLM – jaki CPU i ile RAM ma dziś sens?

W przypadku modeli językowych i zadań generatywnych, gdzie czas odpowiedzi i równoległość mają znaczenie, CPU przestaje być „tylko” obsługą systemu – zaczyna pełnić rolę wspierającą inference. Jeśli masz do czynienia z dużymi modelami transformatorowymi (np. BERT, GPT, T5), preprocessing i obsługa wejść/wyjść, batchowanie zapytań czy analiza kontekstu potrafią solidnie obciążyć procesor, szczególnie przy inferencji w czasie rzeczywistym. Dlatego serwer inference z myślą o LLM powinien mieć minimum 32 rdzenie fizyczne, a często więcej – 64 lub 96 w środowiskach enterprise.

Do tego dochodzi pamięć RAM – jeśli aplikacja ma działać sprawnie bez niepotrzebnych opóźnień, 128–256 GB ECC DDR5 to dziś rozsądna baza, zwłaszcza jeśli serwer ma równolegle obsługiwać kilka modeli lub instancji kontenerowych.

Wśród rekomendowanych modeli warto wskazać Supermicro SYS-421GE-TNHR, Lenovo ThinkSystem SR670 V2 oraz Dell PowerEdge R760xa, które pozwalają na pełną elastyczność pod względem CPU-GPU, są skalowalne i wspierają PCIe Gen5 oraz NVMe Gen4. Nie bez znaczenia jest też to, że większość z nich obsługuje serwis przez iDRAC/IMM/IPMI, co znacznie upraszcza zarządzanie w środowisku produkcyjnym. Dobór CPU i RAM-u nie może być przypadkowy – to on warunkuje, jak skutecznie GPU poradzi sobie z inference pod ciągłym obciążeniem.

Edge AI server w terenie – kompaktowe, szybkie, gotowe na monitoring i IoT

Nie każda infrastruktura inference działa w datacenter. Coraz więcej wdrożeń odbywa się w zakładach przemysłowych, punktach sprzedaży, szpitalach, transporcie czy systemach monitoringu – czyli wszędzie tam, gdzie dane trzeba analizować lokalnie i natychmiast. W takim środowisku edge AI server musi być kompaktowy, cichy, energooszczędny i odporny na zmienne warunki pracy, a jednocześnie wystarczająco mocny, by wykonać inference w czasie rzeczywistym.

Modele takie jak NVIDIA Jetson AGX Orin, Lenovo SE350 lub Dell PowerEdge XR4000 zostały zaprojektowane właśnie pod ten scenariusz. Mają wbudowane akceleratory GPU inference, działają bez wentylatorów (lub z aktywnym chłodzeniem zamkniętym), a ich TDP często nie przekracza 250 W dla całej jednostki.

Co ważne – wiele z nich ma kompatybilność z systemami zarządzania kontenerami (np. K3s, Docker) i może pracować offline, z synchronizacją danych dopiero po sieci. Takie rozwiązania to dziś nie ciekawostka, tylko realna alternatywa dla mini-datacenter – szczególnie gdy potrzebujesz AI przy linii produkcyjnej, na granicy, w pojeździe czy w systemie CCTV. Edge inference to nie przyszłość – to standard w wielu branżach, który już teraz zmienia sposób przetwarzania danych.

Wydajne i tanie? Te konfiguracje serwerów inference nie wymagają miliona na start

Wbrew pozorom, wdrożenie AI inference nie musi zaczynać się od faktury z sześcioma zerami. Jeśli znasz swoje obciążenie i jesteś w stanie przewidzieć liczbę zapytań, można zbudować wydajną, skalowalną i stabilną platformę za ułamek ceny „enterprise-ready”. Przykłady? Dell PowerEdge R660xs z A10 lub A2, Lenovo SR645 z 2x EPYC 7313 i RTX 6000 Ada, a nawet towerowy Dell T560 z RTX 4070 Ti Super i 256 GB RAM – wszystkie te konstrukcje są dostępne w konfiguracjach gotowych do inference i przetestowanych pod kątem obciążeń AI.

Najważniejsze, by nie przepłacać za funkcje, z których nie skorzystasz. Jeśli nie potrzebujesz 8xGPU, nie inwestuj w serwer z 4 zasilaczami i 3U – skup się na optymalnej konfiguracji, którą łatwo serwisować i rozbudowywać. Do tego warto wdrożyć warstwę programową jak Triton, OpenVINO lub ONNX Runtime, które pomogą Ci maksymalnie wykorzystać to, co masz. Czasem lepsze efekty przyniesie dobrze skonfigurowany serwer inference z jednym A10 niż źle obciążony serwer z dwoma L40s. AI inference to gra o balans – nie tylko mocy, ale też budżetu, efektywności i kontroli.

Czy każda firma potrzebuje dedykowanego inference node’a? Kiedy lepiej hybryda

Nie każda organizacja musi od razu stawiać dedykowaną infrastrukturę inference. Dla wielu firm bardziej opłacalnym i elastycznym rozwiązaniem może być hybryda – czyli połączenie lokalnych serwerów inference z zasobami chmurowymi lub edge node’ami. Taki model sprawdza się szczególnie w przypadku nieregularnych obciążeń, dynamicznie zmieniających się projektów, lub wtedy, gdy jedna instancja inference działa stale, a inne tylko tymczasowo (np. w kampaniach marketingowych, sezonowym trafficu).

W tym scenariuszu możesz postawić lokalny AI inference node w biurze (np. Dell T560 z A10), połączyć go z maszyną edge w zakładzie (np. Jetson Orin lub Lenovo SE350), a całość spięta jest z centralnym API w chmurze. To elastyczne i skalowalne rozwiązanie, które daje kontrolę nad kluczowymi danymi, a jednocześnie nie blokuje szybkich eksperymentów. Warto pamiętać, że serwer inference nie zawsze musi obsługiwać wszystko – czasem lepiej zaprojektować architekturę modularnie, z podziałem na typy zadań, lokalizacje i SLA. Dzięki temu unikasz zarówno przeciążeń, jak i niepotrzebnych inwestycji. Inference w 2025 roku to już nie tylko wydajność – to przede wszystkim rozsądna strategia operacyjna.