HBM, czyli High Bandwidth Memory, to technologia, która w ostatnich latach stała się nieodzownym elementem sprzętu wykorzystywanego w AI, HPC i centrach danych. Nie chodzi tu tylko o kolejną wersję pamięci – chodzi o kompletnie nową architekturę, która pozwala akceleratorom działać szybciej, sprawniej i efektywniej energetycznie. W tym wpisie zobaczysz, dlaczego inżynierowie sztucznej inteligencji kochają HBM, jak wygląda jej rozwój, ile naprawdę kosztuje – i dlaczego, mimo tych kosztów, nikt już nie patrzy w stronę klasycznych DRAM-ów.

HBM to nie tylko nowy typ pamięci – to architektura pod AI, jakiej do tej pory nie było

Zacznijmy od podstaw. High Bandwidth Memory (HBM) to technologia DRAM zaprojektowana z myślą o maksymalnej przepustowości i minimalnym zużyciu energii, wykorzystywana głównie w układach graficznych i akceleratorach AI. W odróżnieniu od klasycznych modułów DDR lub GDDR HBM opiera się na wertykalnym ułożeniu chipów DRAM połączonych przy pomocy TSV (Through-Silicon Vias) i zintegrowanych z procesorem przy użyciu interposerów krzemowych. To nie jest tylko nowy typ kości – to zupełnie nowy sposób myślenia o dostępie do pamięci.

W praktyce ta architektura oznacza jedno: znacznie krótsze ścieżki sygnałowe, wyższą gęstość upakowania i niespotykaną szerokość magistrali danych. Jeden stos HBM może mieć magistralę o szerokości aż 1024 bitów, podczas gdy GDDR zwykle operuje na 32 bitach. HBM3E, wprowadzona w 2023 roku, osiąga do 1229 GB/s przepustowości przy 48 GB pojemności na stos, co już dziś pozwala GPU obsługiwać ogromne zbiory danych bez zatykania buforów.

A to dopiero początek – HBM4 (planowane na 2026) ma dojść do 1,6 TB/s przy 64 GB pojemności. W kontekście infrastruktury AI czy HPC to zmiana reguł gry, która umożliwia skalowanie obciążeń bez przenoszenia bottlenecków na poziom RAM.

Dlaczego HBM wygrywa z DDR i GDDR? Przepustowość, opóźnienia i zużycie energii nie zostawiają złudzeń

Tradycyjna pamięć DRAM – niezależnie czy mówimy o DDR5, GDDR6 czy LPDDR – po prostu nie daje rady, jeśli chodzi o przepustowość wymaganą przez współczesne układy AI. HBM nie tylko oferuje znacznie większą szerokość interfejsu, ale też robi to przy niższym napięciu i mniejszym zużyciu energii. W konkretnych liczbach: HBM zużywa od 3,5 do 4,5 razy mniej energii w warstwie PHY niż GDDR6, przy tej samej przepustowości. To oznacza nie tylko oszczędność energetyczną, ale też mniejsze wymagania termiczne i większą efektywność chłodzenia – kluczowe przy pracy w serwerowniach czy centrach danych.

Różnice w przepustowości są równie znaczące. GDDR6 kończy się w okolicach 600 GB/s, natomiast HBM3E pozwala osiągnąć aż 1,2 TB/s. Z kolei latencje dostępu do danych są niższe nie tylko dzięki fizycznej bliskości chipów, ale też dzięki eliminacji części opóźnień wynikających z klasycznego layoutu płyty głównej. W efekcie model AI może nie tylko uczyć się szybciej, ale też szybciej wnioskować – i to bez przestojów wynikających z czekania na dostęp do RAM. Dlatego jeśli Twoja infrastruktura korzysta z intensywnych obciążeń obliczeniowych, przejście na HBM to nie opcja – to warunek stabilnego wzrostu.

AI kocha HBM, bo nie ma wyjścia – tradycyjne DRAM nie nadąża za modelami

Nie chodzi tylko o to, że HBM jest szybsza. Chodzi o to, że modele sztucznej inteligencji nie dają dziś innego wyboru. Kiedy masz do czynienia z setkami miliardów parametrów, dziesiątkami tysięcy tokenów i dziennymi wsadami danych liczonymi w petabajtach – każda mikrosekunda dostępu do pamięci zaczyna być wąskim gardłem. Tradycyjna DRAM – nawet w wersji DDR5 – nie jest w stanie zapewnić takiej przepustowości i gęstości jak HBM. W efekcie maszyna czeka. I to nie na GPU, tylko na RAM.

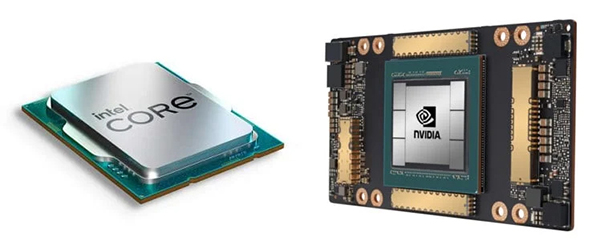

High Bandwidth Memory powstała dokładnie po to, żeby tego problemu nie było. GPU i akceleratory AI, takie jak NVIDIA H100, AMD MI300 czy Intel Gaudi 3, mają tak ogromne zapotrzebowanie na przepustowość, że bez HBM ich potencjał byłby niewykorzystany. Jak powiedział Jim Handy z Objective Analysis – bez HBM musiałbyś mieć kilka procesorów zamiast jednego, co i tak nie dawałoby podobnego efektu. HBM upraszcza architekturę systemu, zmniejsza liczbę komponentów, a jednocześnie skaluje się liniowo wraz z rosnącymi wymaganiami modeli AI. Dzięki temu nie musisz rozbudowywać całej platformy – wystarczy, że używasz lepszego interfejsu pamięci.

Ile kosztuje HBM i dlaczego mimo to jest warte każdych pieniędzy?

Wysoka cena HBM nie jest tajemnicą – i rzeczywiście może zaskoczyć. Jeden gigabajt HBM kosztuje około 10,6 dolara, podczas gdy DRAM to koszt rzędu 2,9 dolara, a DDR5 nawet jeszcze mniej. Ale przy HBM nie płacisz za pojemność. Płacisz za przepustowość, efektywność energetyczną i brak bottlenecków, które w systemach AI przekładają się bezpośrednio na czas trenowania modeli, a więc na koszty operacyjne. Według analiz kosztowych, GPU NVIDIA H100 kosztuje około 3000 USD, z czego połowa ceny to sama pamięć HBM dostarczana przez SK Hynix.

Mimo tej ceny marża operacyjna dla producentów sięga nawet 87% – co oznacza, że klienci korporacyjni są gotowi płacić, bo zyskują przewidywalność i wydajność. To się po prostu spina. Model wytrenujesz szybciej, system zużyje mniej energii, a efektywniejsze zarządzanie obciążeniem pozwoli Ci lepiej wykorzystać zasoby sprzętowe. I nawet jeśli na starcie płacisz więcej, realny ROI (return on investment) w ujęciu rocznym okazuje się bardziej korzystny niż przy tanich systemach z klasycznym DRAM. Szczególnie jeśli budujesz infrastrukturę na lata, a nie na kwartał.

Custom HBM to przyszłość – pełna kontrola nad przepustowością i zużyciem

Standard HBM to już potężne narzędzie, ale coraz więcej firm idzie krok dalej. Custom HBM (cHBM) pozwala projektować pamięć w sposób dopasowany do konkretnych zadań – np. AI inference, grafika 3D czy symulacje kwantowe. Dzięki architekturze 2.5D interposerom krzemowym i własnym kanałom komunikacyjnym, firmy takie jak Marvell tworzą dedykowane układy cHBM, które przekraczają ograniczenia klasycznych interfejsów. W praktyce oznacza to większą gęstość danych, lepszy stosunek mocy do wydajności i lepszą kontrolę nad topologią systemu.

To już nie tylko pamięć – to element projektu całej platformy. Możesz decydować, ile kanałów wykorzystujesz, jak rozkładasz dane i jakie latencje akceptujesz. W świecie, gdzie różnice w wydajności są liczone nie w procentach, ale w czasach trenowania, ta elastyczność daje realną przewagę. Według Samsunga udział custom HBM ma przekroczyć 50% w najbliższych latach, bo coraz więcej firm potrzebuje precyzyjnego dopasowania sprzętu do obciążenia. I wbrew pozorom, to wcale nie jest opcja tylko dla gigantów – wystarczy, że działasz w niszy, gdzie standardowa konfiguracja Cię ogranicza.

Uwaga na dostępność – HBM może zabraknąć szybciej, niż zdążysz zaplanować projekt

Obecnie na rynku funkcjonują tylko trzej dostawcy HBM: SK Hynix, Samsung i Micron, a możliwości produkcyjne są ograniczone przez technologię pakowania 2.5D i wymagające procesy testowania. TSMC ma w tym segmencie dominującą pozycję, ale i oni sygnalizują ograniczenia przepustowości w fabrykach. Już dziś ceny HBM rosną o 5–10% kwartalnie, a raporty z rynku sugerują, że dostępność będzie problemem strategicznym przez najbliższe dwa lata.

Jeśli więc myślisz o wdrożeniu infrastruktury AI w najbliższym czasie – uwzględnij dostępność HBM jako kluczowy parametr planowania. Nie chodzi tylko o to, ile sztuk potrzebujesz, ale kiedy musisz je zakontraktować, z kim negocjować dostawy i jak zarządzać magazynowaniem. Wiele firm już dziś podpisuje wieloletnie umowy z dostawcami, by zabezpieczyć ciągłość łańcucha dostaw. Jeśli w Twoim harmonogramie projektowym pamięć traktowana jest jako ostatni punkt „do wyboru”, ryzykujesz, że nie zdążysz jej kupić, zanim wszystko pójdzie w produkcję. A wtedy nawet najlepszy GPU nie zrobi różnicy.