Sieć komputerowa to coś więcej niż kable i routery – to fundament działania każdej infrastruktury IT w firmie. W środowiskach enterprise sieć łączy nie tylko komputery, ale całe klastry, mikroserwisy, magazyny danych, urządzenia IoT i systemy bezpieczeństwa. To dzięki niej komunikują się ze sobą aplikacje biznesowe, działają backupy, działa CI/CD i dostęp do usług zdalnych. Zrozumienie, czym jest sieć komputerowa w tym kontekście, to nie teoria, ale konkretna wiedza, która pozwala projektować rozwiązania odporne na awarie i skalowalne.

Sieć komputerowa to nie tylko przewód i adres IP – jak zrozumieć jej rolę w nowoczesnym IT

W środowiskach enterprise pojęcie sieci komputerowej oznacza coś znacznie więcej niż łączność między urządzeniami. To kręgosłup infrastruktury IT, na którym opiera się komunikacja między usługami, dostęp do aplikacji, kontrola uprawnień czy monitorowanie bezpieczeństwa. Struktura sieci komputerowej w serwerowniach obejmuje nie tylko fizyczne kable i urządzenia sieciowe, ale również warstwy logiczne – VLAN-y, segmentację, protokoły i reguły routingu, a także zarządzanie zasobami przez SDN. Sieć nie działa już tylko jako pasywny kanał transmisyjny – to dynamiczny, aktywnie zarządzany system, który wpływa na to, czy aplikacje skalują się płynnie i czy systemy ERP, CRM lub hurtownie danych działają zgodnie z oczekiwaniami.

Zrozumienie sieci jako środowiska usługowego jest dziś kluczowe. Coraz częściej masz do czynienia z hybrydowymi topologiami, gdzie rozległa sieć komputerowa łączy zasoby lokalne z usługami w chmurze – i wszystko musi działać jako jeden spójny organizm. Dlatego planując nowoczesne środowisko, nie możesz ograniczać się do fizycznych komponentów. Trzeba brać pod uwagę routing między podsieciami logicznymi, kontrolę dostępu, redundancję tras, wsparcie dla overlay/underlay i integrację z systemami automatyzacji. Bez tego żadne CI/CD, backup czy disaster recovery nie będą niezawodne.

Klient-serwer, peer-to-peer i reszta – architektury, które trzeba umieć rozróżnić

W sieciach klasy enterprise nadal dominuje model klient-serwer, w którym zasoby – aplikacje, dane, usługi – znajdują się na centralnym serwerze, a urządzenia końcowe korzystają z nich zdalnie. Ten model umożliwia pełną kontrolę nad ruchem, dostępami i zasobami, ale wymaga dobrze zaprojektowanej architektury – zarówno sprzętowej, jak i logicznej. To rozwiązanie pozwala minimalizować ryzyko naruszenia danych, usprawniać zarządzanie użytkownikami, a także wdrażać polityki bezpieczeństwa sieci komputerowych.

Trzeba jednak pamiętać, że każda awaria po stronie serwera centralnego przekłada się na niedostępność całej usługi.

Z drugiej strony mamy architekturę peer-to-peer, której nie spotyka się już w środowiskach produkcyjnych – ale może być przydatna w testach, symulacjach lub tam, gdzie urządzenia muszą wymieniać się danymi lokalnie, bez centralnego zarządzania. Znajomość obu modeli i umiejętność ich rozdzielenia przy projektowaniu sieci – to kluczowa kompetencja, gdy chcesz uniknąć projektowych błędów. Budowa sieci komputerowej powinna zaczynać się od wyboru architektury logicznej, a dopiero potem przechodzisz do planowania routingu, adresacji, przełączników czy klas QoS. Bez tego każda inwestycja w sprzęt będzie jedynie drogim zlepkiem urządzeń bez spójności.

Co wchodzi w skład nowoczesnej sieci komputerowej? Nie tylko router i switch

Mówiąc o elementach sieci komputerowych w środowisku serwerowym, trzeba rozróżnić co najmniej pięć głównych warstw:

- urządzenia końcowe (np. serwery, stacje robocze, urządzenia IoT),

- urządzenia sieciowe (routery, przełączniki, access pointy),

- media transmisyjne (światłowody, skrętki, łącza radiowe),

- protokoły komunikacyjne oraz oprogramowanie zarządzające.

Dziś równie ważna co port RJ-45 jest kontrola nad tym, kto i kiedy może z danego portu korzystać, z jaką przepustowością i do jakich zasobów ma dostęp. Bez inteligentnego zarządzania tym ruchem nawet najlepszy sprzęt nie rozwiąże podstawowych problemów z bezpieczeństwem czy wydajnością.

W nowoczesnym data center nie wystarczy kupić „dobry sprzęt”. Potrzebujesz integracji z narzędziami do monitoringu ruchu (np. NetFlow, Zabbix), segmentacji sieci (VLAN, mikrosegmentacja), redundancji połączeń i wsparcia dla protokołów dynamicznych (OSPF, BGP). Do tego dochodzi coraz popularniejsze zarządzanie warstwą sieciową przez oprogramowanie – SDN (Software Defined Networking). Dzięki temu możesz reagować automatycznie na przeciążenia, zmieniać trasy pakietów bez restartu usług i tworzyć sieci logiczne niezależne od fizycznego okablowania.

Segmentacja i bezpieczeństwo sieci komputerowej – kiedy podsieć to za mało?

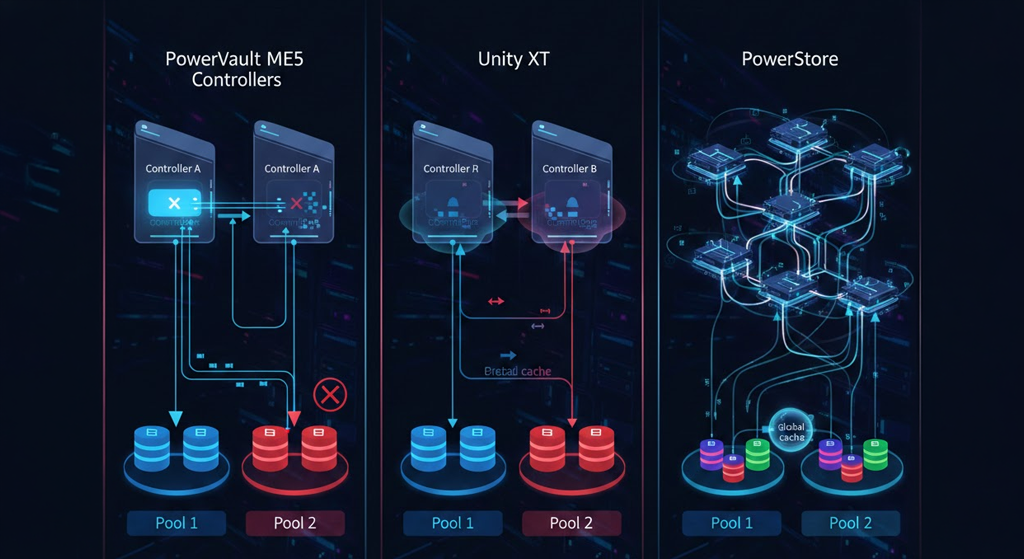

Jeśli do tej pory dzieliłeś sieć wyłącznie na podstawie fizycznych podsieci IP – czas to zmienić. Nowoczesne środowiska produkcyjne wymagają segmentacji na poziomie VLAN, mikrosegmentacji i polityk ruchu, które pozwalają blokować, limitować i śledzić pakiety między poszczególnymi elementami infrastruktury. Bezpieczeństwo sieci komputerowych nie może polegać wyłącznie na firewallu na brzegu. To polityki w switchach, reguły ACL, separacja portów trunk/access, a także kontrola na poziomie aplikacyjnym.

Segmentacja logiczna nie tylko poprawia bezpieczeństwo, ale również wydajność – zmniejsza broadcast, poprawia zarządzalność i pozwala wdrażać reguły QoS per grupa. Dla dużych firm, które korzystają z ERP, CRM, systemów HR i masy narzędzi SaaS – to jedyny sposób, by utrzymać porządek i szybkość działania usług. Mikrosegmentacja pozwala np. odizolować aplikację księgową od Internetu, nie zamykając przy tym całej sieci. W praktyce oznacza to mniej przypadków lateral movement w przypadku ataku i szybszą reakcję.

Chmura, SDN, overlay – nowoczesna sieć komputerowa, która nadąża za skalowaniem

Dzisiejsza sieć komputerowa w warunkach enterprise musi być dynamiczna, elastyczna i gotowa na skalowanie – czyli taka, która bez przeszkód połączy fizyczne serwery w lokalnej serwerowni z zasobami w AWS, Azure czy GCP. I tu właśnie wchodzą rozwiązania takie jak overlay/underlay, SDN, mikrosegmentacja i Network as a Service. Każdy z tych elementów pozwala zarządzać siecią tak, by nie trzeba było przepinać kabli za każdym razem, gdy zmienia się topologia środowiska. SDN pozwala centralnie zarządzać regułami routingu i dostępem, a overlay – tworzyć logiczne sieci nad infrastrukturą fizyczną bez konieczności naruszania jej struktury.

Coraz częściej w firmach wdraża się model NaaS (Network as a Service) – sieć jako usługa, w której operator chmury udostępnia gotowe rozwiązania: VPN, load balancing, firewalle, segmentację i polityki ruchu. Dzięki temu możesz rozbudowywać środowisko IT bez inwestowania w kolejne przełączniki czy szafy rackowe. Co więcej, masz dostęp do zaawansowanego monitoringu, szyfrowania, logowania ruchu i zgodności z normami RODO czy ISO. W efekcie nawet mniejsze firmy mogą korzystać z architektury, która jeszcze 5 lat temu była zarezerwowana dla banków. Jeśli Twoja sieć nie nadąża za tempem rozwoju aplikacji, czas ją zredefiniować. Bo dziś to nie aplikacje dopasowują się do infrastruktury – to infrastruktura musi nadążać za aplikacjami.